Testes do algoritmo de corte de imagens do Twitter viraram assunto na rede social neste sábado (19). Um usuário publicou diferentes versões da mesma imagem com fotos do senador norte-americano Mitch McConnell, que é branco, e do ex-presidente Barack Obama, que é negro. O sistema da rede social, que "escolhe" uma parte da imagem para destacar, selecionou McConnell.

Trying a horrible experiment...

— Tony “Abolish (Pol)ICE” Arcieri 🦀 (@bascule) September 19, 2020

Which will the Twitter algorithm pick: Mitch McConnell or Barack Obama? pic.twitter.com/bR1GRyCkia

Outros internautas responderam à publicação fazendo testes alterando o fundo, brilho e contraste, proporções das fotos, expressões faciais e até as cores das gravatas. Os resultados foram variados e até inusitados - um usuário conseguiu destacar Obama removendo os óculos de McConnell e inserindo-os no rosto do ex-presidente -, mas a tendência pela foto de McConnell ainda prevaleceu.

No Brasil, o advogado Joel Luiz também fez o teste e obteve os mesmos resultados do post original.

Replicando um teste gringo.

— Joel Luiz (@joelluiz_adv) September 20, 2020

Vamos vê qual o algoritmo do Twitter vai escolher: Mitch McConnell ou Barack Obama? pic.twitter.com/FCYyJCKMWh

Inteligência artificial e "saliência"

Embora demonstre uma clara disparidade entre rostos brancos e negros, o teste não significa que a rede social tenha tomado uma decisão consciente de perpetuar a discriminação na internet. A explicação para esse fenômeno tem a ver com o conceito de machine learning: o sistema "aprende" a categorizar as imagens de acordo com as referências de uma base de dados.

O Twitter não se baseia em reconhecimento facial, mas identifica e corta as imagens a partir da "saliência", isto é, a interpretação da parte mais importante ou chamativa do arquivo. "Uma região com alta saliência significa que tem maior probabilidade de alguém olhar para lá quando estiver observando livremente a imagem. Acadêmicos estudaram e mediram saliência rastreando o movimento dos olhos, que grava os pixels nos quais os olhos focam mais. Em geral, as pessoas tendem a prestar mais atenção em rostos, textos, animais, mas também outros objetos e regiões de alto contraste", diz uma publicação de 2018 no blog oficial da empresa.

A rede social não se pronunciou oficialmente sobre a polêmica, mas Dantley Davis, chefe de Design e Pesquisa da empresa, assumiu a responsabilidade em seu perfil pessoal. "É 100% nossa culpa. Ninguém deveria dizer o contrário. O próximo passo agora é resolver", tweetou Davis na manhã deste domingo. Ele se comprometeu a investigar o problema e manifestou a opinião de que a rede deveria parar de cortar imagens de qualquer forma.

Outros casos

Na última sexta (18), um estudante compartilhou pelo Twitter imagens de sua reunião com um professor negro na plataforma Zoom. As imagens mostram que o rosto do professor desapareceu completamente quando ele inseriu um fundo virtual, que depende do reconhecimento de rostos para separar o usuário do restante do ambiente. O aluno, branco, não teve o mesmo problema.

any guesses? pic.twitter.com/9aIZY4rSCX

— Colin Madland (@colinmadland) September 19, 2020

Segundo Jen Golbeck, professora da Universidade Maryland e diretora do Laboratório de Interação Humano-Computador, falhas nesses sistemas são efeitos colaterais dos algoritmos. "O sistema procura rostos, e todo reconhecimento facial funciona muito melhor para pessoas brancas porque aprende com mais exemplos de gente branca", tweetou a pesquisadora.

Para ela, engenheiros precisam pensar em processos de checagem de todo tipo de preconceito ou viés. A falta de diversidade na área da tecnologia também ajuda a explicar esse fenômeno, já que desenvolvedores de outros grupos étnicos e mulheres poderiam alertar homens brancos a respeito de problemas que nem haviam sido considerados por eles.

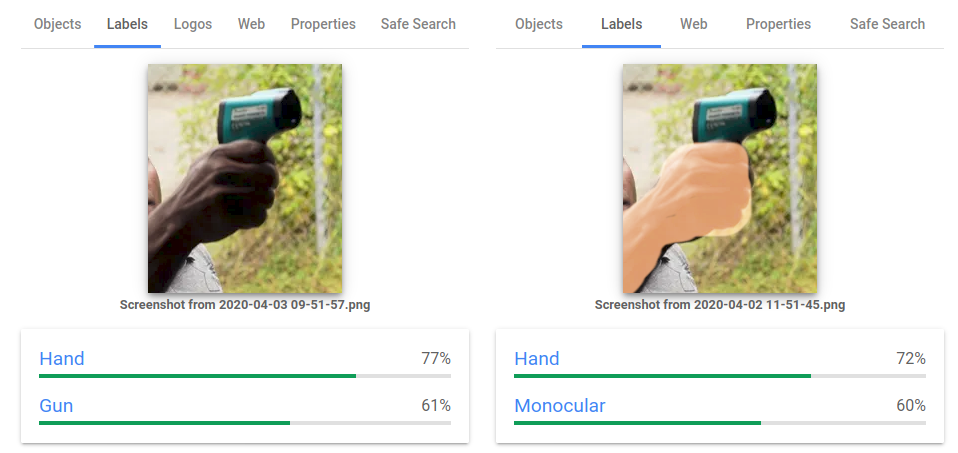

Em abril deste ano, o Google pediu desculpas publicamente por outra situação desse tipo: um sistema de categorização de imagem produziu resultados diferentes para fotos com pele negra e branca.

Numa imagem que mostrava uma mão negra segurando um termômetro de mão (do tipo usado na entrada de estabelecimentos durante a pandemia), o sistema marcou "mão" e "arma". A mesma foto com uma mão branca teve as tags "mão" e "monocular", instrumento para enxergar objetos distantes.

REDES SOCIAIS